🚀 Самостоятельный аудит сайта, часть 2 — SEO-аудит

Продолжаем серию материалов об аудите сайта своими руками. В этом посте — SEO-аудит. Пока писали статью, поняли, что в один пост не уместится все, что мы хотим разобрать. Это первая часть, а здесь продолжение про аудит контента.

В статье:

- Доступность сайта для индексации, robots, sitemap

- Канонические URL

- Архитектура сайта и уровень вложенности страниц

- Внутренние ссылки

- Внешние ссылки

- SSL-сертификат

- Пагинация в каталоге

Доступность сайта для индексации, корректность Robots.txt и Sitemap

Страницы сайта, за исключением служебных, должны быть доступны роботам для сканирования и индексации. Закрыть от поисковых ботов нужно дубли, панель администратора, корзину, другие технические файлы, которые не должны быть в выдаче.

Файл robots.txt

Прописать доступы можно в файле robots.txt — это текстовый файл с указаниями по индексированию для роботов. Файл robots.txt использует систему директив — правил, задаваемых поисковому роботу.

«User-agent:» — основная директива robots.txt. Используется для конкретизации поискового робота, которому будут даваться указания. Например, User-agent: Googlebot — все команды, следующие после этой директивы, будут касаться исключительно индексирующего робота Google;

После основной директивы «User-agent:» следуют конкретные команды:

- «Disallow:» — директива запрета индексации в robots.txt.

- «Allow:» — директива разрешения индексации. На практике «Allow:» используется редко, поскольку поисковый бот применяет ее автоматически.

- «Sitemap:» указывает индексирующему роботу путь к файлу Карты сайта. Помогает проиндексировать Карту, чтобы страницы сайта быстрее попали в поисковую выдачу.

Полезное по теме:

Как правильно составить robots.txt

Сгенерировать файл robots.txt для вашего сайта можно с помощью сервиса PR-CY.

Как проверить правильность robots.txt:

- название файла — «robots.txt» и только такое;

- файл находится в корневом каталоге — https://site.com/robots.txt;

- файл robots.txt один единственный;

- формат — .txt;

- вес — до 32 КБ;

- кодировка файла — UTF-8;

- доступен, отдает HTTP-код 200 ОК;

- каждый префикс URL на отдельной строке;

- состоит только из латиницы, кириллические ссылки сконвертированы в Punycode.

Боты относятся к файлу, как к рекомендациям: запрещенная вами страница может попасть в индекс, если на нее ведет ссылка с доступной боту страницы, по которой он может перейти.

Если вы не хотите, чтобы страница попала в выдачу Google, закройте доступ к ней паролем или «nofollow».

Файл sitemap.xml

Файл sitemap.xml, то есть Карта сайта, помогает роботам сканировать проект. Файл сообщает роботам поисковых систем:

- какие страницы сайта нужно индексировать;

- как часто обновляется информация на страницах;

- какие страницы наиболее важны для индексации.

В файле нужно собрать список страниц, которые должны быть в индексе. Закрытые для ботов, неканонические, неактуальные, удаленные URL в Карту добавлять не нужно.

Поисковый робот может не найти некоторые страницы или неверно определить их важность. Проблемными обычно становятся динамически создаваемые страницы или страницы, к которым ведет длинная цепочка ссылок. Файл Sitemap решает эти проблемы.

Полезное по теме:

Как составить Карту сайта правильно

Как проверить правильность файла sitemap.xml:

- не больше 50 тыс URL в одной Карте;

- размер до 50 Мб в несжатом виде;

- формат — XML;

- находится на том же домене, что и сайт;

- состоит из латиницы с цифрами;

- отдает 200 ОК;

- все данные в кодировке UTF-8;

- ссылки с одинаковым синтаксисом;

- в файле нет URL идентификаторов сессий;

- только канонические URL;

- данные не конфликтуют с содержимым robots.txt, в Карте нет закрытых в robots.txt страниц.

Проверить на ошибки готовый файл Sitemaps.xml можно анализатором Яндекса. Ответы на часто задаваемые вопросы о Sitemap.xml на официальном сайте.

Проверьте, сколько страниц проиндексировали поисковые системы. Вы можете узнать примерное количество страниц в индексе с помощью оператора site:, добавьте после двоеточия адрес сайта. Сравните это количество с общим количеством страниц, которое есть на вашем сайте в открытом доступе для поисковых ботов. Эта информация должна быть у вас на стадии сборки Карты сайта. Либо ее можно узнать, к примеру, после сканирования Screaming Frog, Xenu’s Link Sleuth, другими сервисами.

Значительные различия в количестве страниц могут говорить о проблемах. Если в выдаче далеко не все страницы, возможно, боты не могут их обработать, потому что некоторые разделы для них закрыты, или сайт получил санкции от поисковика. Проверьте уведомления в Консоли и Вебмастере. Если страниц в индексе больше, чем должно быть на самом деле, возможно, движок генерирует дубли, которые и попали в выдачу.

Канонические URL

Бывают ситуации, когда по разным URL открываются одинаковые или минимально различающиеся страницы. К примеру, почему это может быть:

- материал входит сразу в несколько категорий;

- варианты товара с минимальными отличиями доступны по разным адресам;

- у каталога с примененными фильтрами разные URL;

- CMS некорректно настроена.

Страницы могут быть идентичными за исключением расцветки товара. Этого различия недостаточно, чтобы они считались уникальными. Поисковики решат, что это дубли, и могут наложить санкции и понизить контент в выдаче.

Вы можете выбрать самый популярный вариант в качестве канонической, то есть основной версии страницы. Другие цвета будут по-прежнему доступны пользователям, но вес с внешних ссылок на них будет перенаправляться на канонический URL-адрес.

Это нужно для того, чтобы:

- ссылочный вес корректно передавался на нужную версию сайта;

- контент, доступный по нескольким URL, индексировался и ранжировался правильно;

- поисковики не наложили санкции из-за дублей.

Используйте link rel = «canonical». Атрибут link указывает поисковому роботу основную версию документа. Чтобы указать поисковику каноническую страницу, нужно в код каждого дубля добавить между тегами строку:

<link rel=»canonical» href=»http://site.ru/statya1″>

http://site.ru/statya1 — URL страницы, который должен быть основным. Обязательно указывайте полный адрес с http:// и доменом.

Почитать по теме:

Все о rel canonical: как правильно указать и какие ошибки обычно допускают

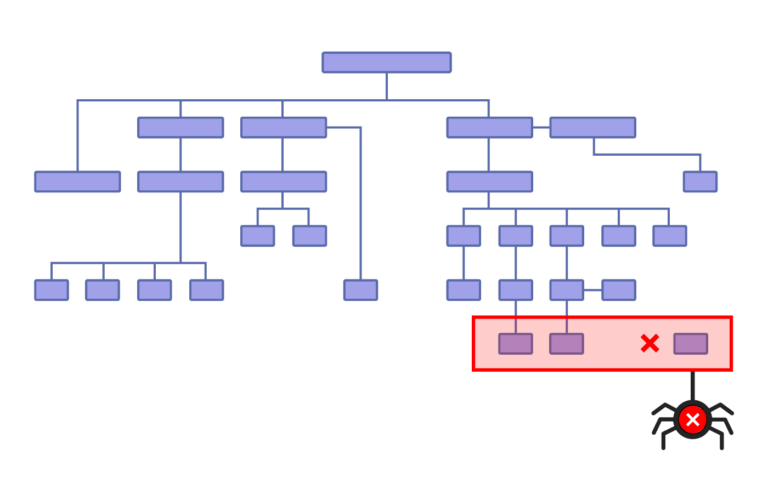

Архитектура сайта и уровень вложенности страниц

Логичная архитектура не даст пользователям заблудиться на сайте, а поисковикам поможет быстрее проиндексировать все страницы. Каждая страница должна участвовать в перелинковке — ссылочной системе сайта. На сайте не нужны:

- «висячие узлы» — страницы, которые сами ни на кого не ссылаются;

- «страницы-сироты» — они лежат в структуре сайта, но на них не ведет ни одна ссылка.

Такие страницы редко встречаются, только если на самописных сайтах без CMS, если веб-мастер ошибется при ручной перелинковке. Когда CMS генерирует страницы, они связаны логикой навигации.

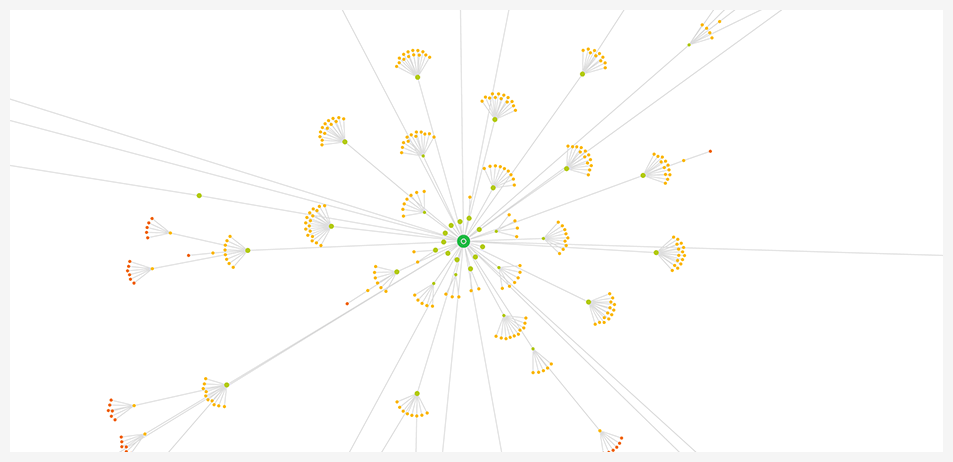

Увидеть структуру сайта в наглядном отображении можно с помощью сервисов для визуализации — Crawl Maps у Sitebulb Website Crawler и WebSite Auditor.

Подробно об архитектуре сайта в статье

Уровень вложенности (УВ) – показатель положения страницы в общей структуре сайта. Определяется по минимальному количеству переходов, которые нужно сделать, чтобы с главной страницы попасть на целевую.

Главная страница сайта всегда имеет УВ 1. Все остальные страницы, на которые можно попасть с главной за один клик, имеют УВ 2, за два клика — УВ 3, и так далее.

Рекомендуем сделать так, чтобы все самые важные страницы были расположены в одном клике от главной, а остальные в 3-4 кликах.

Высокий уровень вложенности влечет несколько проблем:

-

Чем дальше страница от главной, тем меньший ссылочный вес она получает.

-

Высокая вложенность может негативно повлиять на конверсию. Пользователю может надоесть много раз переходить по ссылкам в поисках нужной страницы, особенно, если он смотрит с мобильного.

-

Существует мнение о том, что страницы с высокой вложенностью медленнее индексируются поисковыми роботами или не индексируются вовсе. В любом случае, это не проблема при наличии Карты сайта.

Проблему с высоким УВ можно решить HTML-картой сайта, так делают крупные ресурсы:

- Создается страница с картой, на которой размещаются ссылки на все остальные существующие страницы.

- Ссылка на эту страницу размещается на главной. В итоге все страницы сайта будут иметь УВ не более 3.

HTML карту сайта также можно использовать для поиска нужных страниц. Однако, с точки зрения юзабилити, грамотно организованное меню на главной будет предпочтительнее.

Итак, что нужно проверить:

- уровень вложенности важных страниц не должен быть больше 3-4;

- группы, которые вы сформировали в процессе кластеризации семантического ядра, должны найти все отражение в структуре сайта

- перелинковка затрагивает все страницы сайта, они связаны между собой по тематикам;

- навигация на сайте отражает все нужные пользователям разделы, в ней легко ориентироваться;

- страница с HTML-картой, если вы все-таки решили ее сделать, доступна для пользователей и поисковых ботов.

Внутренние ссылки — перелинковка

Внутренними называются ссылки, которые направляют с одной страницы домена на другую страницу того же домена.

Какая роль у внутренних ссылок:

-

Помочь поисковым роботам находить и индексировать страницы.

Робот поисковой системы изучает страницу A, видит ссылки на страницы B и E и индексирует их. На страницы D и С, на которые ссылок нет, робот попасть не сможет и не проиндексирует их. -

Распределить ссылочный вес между разными по значимости страницами.

Чем ближе к главной находится страница, тем важнее она считается. Страницы, на которые ссылается главная, получают больше всего ссылочного веса. Дальше они распределяют вес по страницам, на которые ссылаются сами. -

Организовать навигацию.

С помощью ссылок аудитория ориентируется на сайте. -

Задержать пользователя на сайте.

Ссылки на другие подходящие по теме страницы могут заинтересовать пользователя, а значит он проведет на сайте больше времени и посетит больше страниц. Поисковики ценят интересные сайты.

Разберем, какие ссылки нужно проверить.

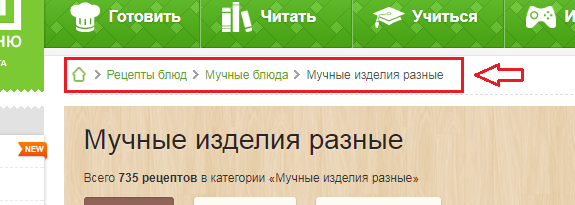

«Хлебные крошки» — элемент навигации по сайту в виде пути от главной страницы до страницы, на которой находится пользователь. Ссылки участвуют в перелинковке и помогают пользователям вернуться на предыдущие уровни каталога.

Проверьте корректность отображения цепочки: она начинается с главной, включает в себя промежуточные разделы и заканчивается текущей страницей. Последняя должна быть не кликабельной, чтобы не получилась циклическая ссылка.

Используйте «хлебные крошки» только если на вашем сайте много контента, который размещен в иерархическом порядке, и не в качестве единственного способа навигации.

Как добавить на сайт «хлебные крошки»

Циклические ссылки — те, которые ссылаются на страницу, на которой и расположены. Поисковый бот перейдет по такой ссылке и окажется на исходной странице. Они бесполезны для пользователей и могут навредить сайту, если их много: бот может счесть их использование попыткой манипуляции, если у них будут спамные анкоры..

Сквозные ссылки — проходят через весь сайт, обычно находятся в шапке и футере. Если они состоят из ключей или отправляют на сторонние сайты, поисковики могут посчитать их спамом. Но сквозные ссылки с естественными анкорами не вредны, они тоже участвуют в перелинковке и передают небольшую часть веса.

Дубли ссылок на одной странице — поисковики учитывают только верхнюю из одинаковых ссылок, так что в дублях нет смысла, если это не обосновано контекстом.

Глубокие ссылки (диплинки) — ссылка не на всю страницу, а на конкретную часть контента, например, на нужный абзац. Такие ссылки должны помочь непопулярным статьям и объемным материалам, в которых информация только частично соответствует пользовательскому запросу.

Кольцевая перелинковка — часто метод применяют в блогах, это выглядит как блок «Материалы по теме» или «Читать еще» со ссылками на другие статьи, подходящие по теме, причем так, чтобы все статьи по этой теме получили ссылки.

Битые ссылки ведут на документ, которого не существует, поэтому отдают код 404. Причиной может быть то, что страницу удалили, перенесли так, что она поменяла URL, скрыли от пользователей и поисковиков. Как их найти и как лучше исправить.

Контролируйте количество ссылок, чтобы распределять ссылочный вес. Он будет делиться между всеми страницами, на которые ведут ссылки. На продвигаемые страницы количество входящих ссылок должно быть больше, чем исходящих, так они получат больший вес.

Не собирайте много ссылок в одном месте, распределяйте их по контенту равномерно — 1 ссылка на 1000 символов.

Ссылка должна соответствовать контексту: окружающий текст должен подходить ей тематически. Связывайте ссылками только близкие по теме материалы.

Комбинируйте анкоры. Анкор — текст ссылки, который заключен внутри HTML тега< a >. В тексте анкоров можно использовать ключевые слова, релевантные целевой странице, нейтральные слова «читать здесь», «тут», ставить безанкорные ссылки в виде URL.

- Анкорная ссылка: Используйте наш сервис для анализа сайта.

- Безанкорная ссылка: Попробуйте генератор анкоров — http://pr-cy.ru/generator/

Не ссылайтесь на одну и ту же страницу с помощью одинаковых анкоров. Поисковики могут склеить такие ссылки, и смысл в их размещении потеряется.

Подробно по теме:

Перелинковка — как работать с внутренними ссылками на сайте

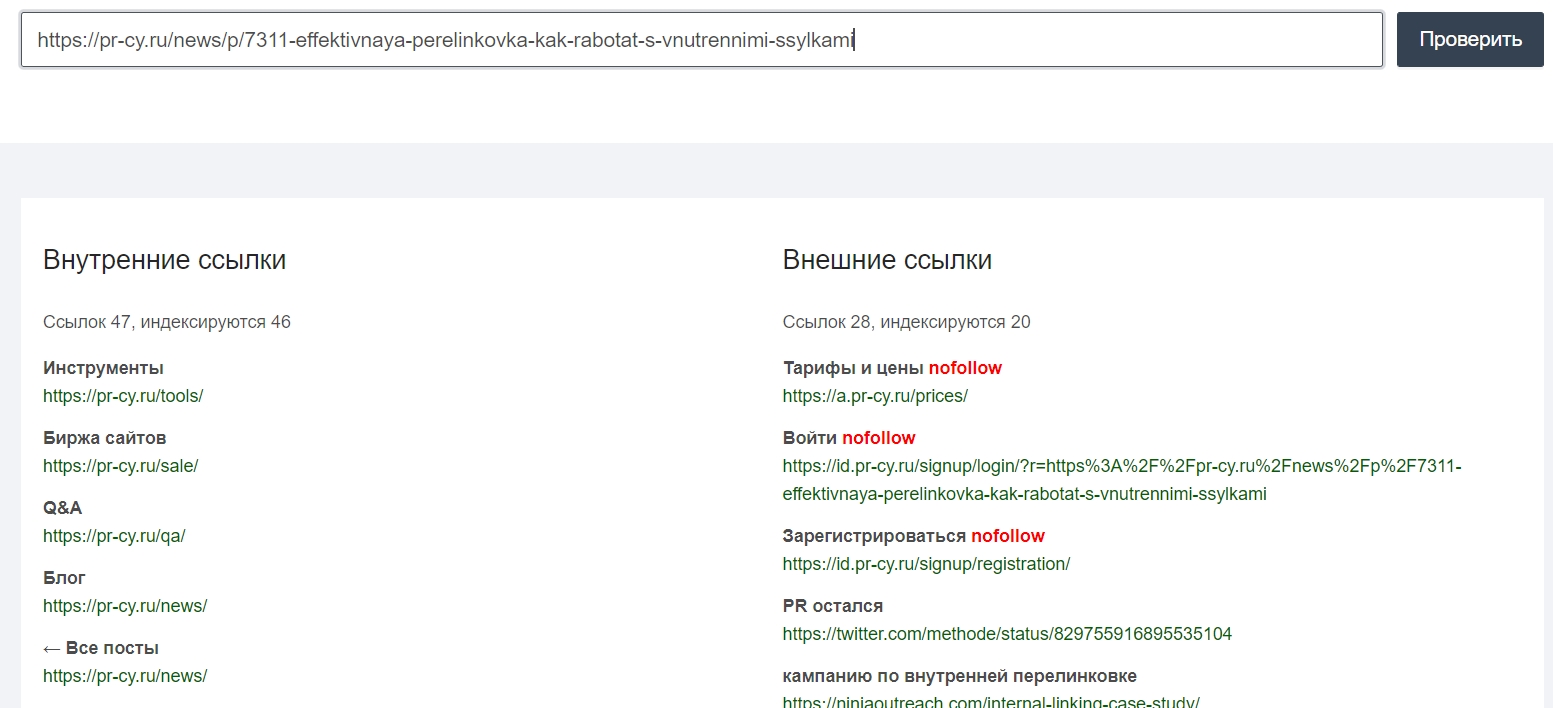

Увидеть список внутренних и внешних ссылок на конкретной странице можно бесплатно в нашем инструменте pr-cy.ru/link_extractor. Он соберет все ссылки, покажет текстовое окружение, URL и определит nofollow.

Внешние ссылки

Это ссылки, которые ведут на сторонний сайт. Внешние ссылки рассматриваются поисковиками как рекомендация полезного контента. Чем чаще другие качественные ресурсы ссылаются на сайт и чем больше веса передают эти ссылки, тем лучше для продвижения сайта.

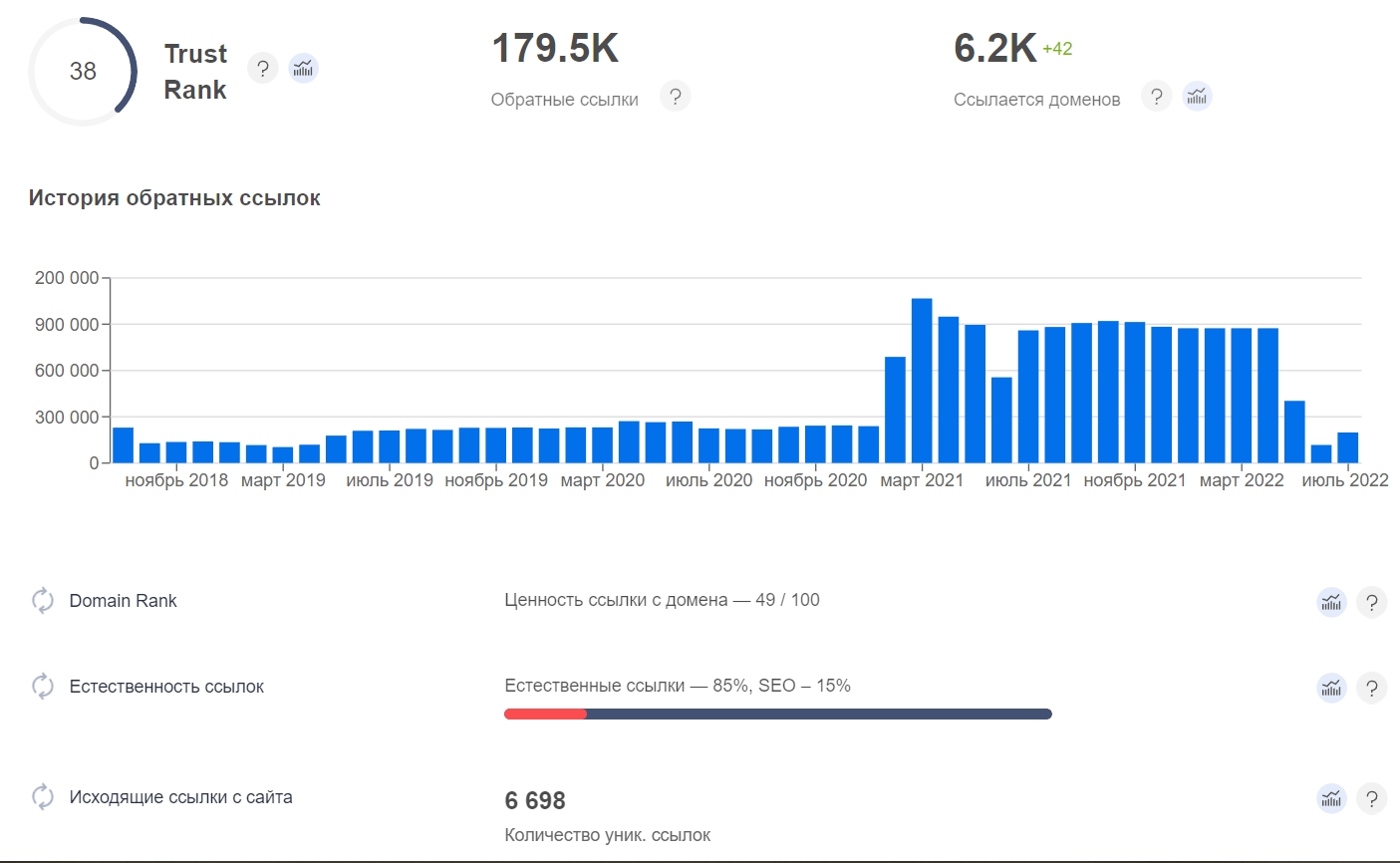

Проанализируйте ссылочный профиль вашего сайта:

-

общее количество ссылок в сравнении с конкурентами;

-

динамику — плавный или стихийный прирост новых ссылок;

-

какие ресурсы ставят на него ссылки: качество доноров, которые ссылаются на ваш сайт. их авторитетность, репутацию, совпадения по тематике, позиции;

-

с каких страниц они это делают;

-

на какие страницы вашего сайта чаще ссылаются;

-

соотношение анкорных и безанкорных ссылок, SEO- и естественных анкоров;

-

ссылка dofollow или nofollow.

Для анализа ссылочного профиля сайта используйте сервис для онлайн-аудита. Он отобразит соотношение анкоров, покажет количество ссылок и соберет в табличку свежие:

Увеличение ссылочной массы помогает наращивать трафик, продвигать сайт среди целевой аудитории с помощью тематических запросов, а еще находить дополнительные сегменты целевой аудитории. Например, на сайте интернет-магазина по продаже товаров, сопутствующих вашему, или в разделе торговой площадки с аналогичными вашему товарами.

Подробнее о внешних ссылках в материалах на нашем сайте: раз, два.

SSL-сертификат

SSL, Secure Sockets Layer — это протокол, который дает возможность установить защищенное соединение между интернет-ресурсом и браузером. SSL не дает сторонним образом вмешаться в соединение – перехватить данные, подделать или изменить.

Происходит это путем шифрования данных с использованием двух типов ключей – приватного и публичного. Скрытый приватный ключ хранится на сервере, а публичный предоставляется пользователю, который заходит на сайт. Соответствие приватного и публичного ключей обеспечивает посетителю безопасность использования сайта, на котором установлен SSL-сертификат.

Сертификат особенно важен для сайтов, которые используют персональные данные пользователей и подразумевают онлайн-оплату товаров или услуг.

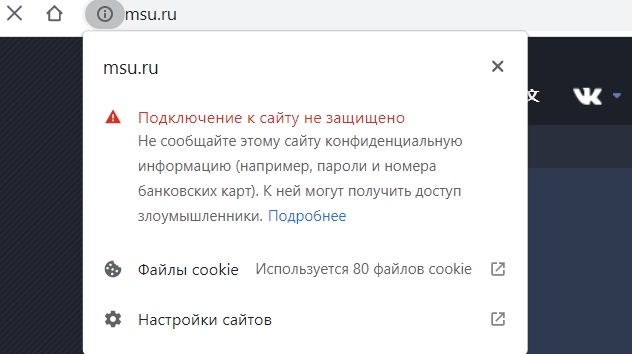

SSL-сертификат позволяет использовать защищенный HTTPS-протокол. По заявлению Google,он влияет на рост позиций в выдаче, а также повышает уровень доверия посетителей к сайту. Пользователи увидят предупреждение в браузере:

Три основных вида SSL-сертификатов:

-

Сертификат доверенного центра сертификации

Этот сертификат означает, что компания, которая использует сертификат предоставила центру сертификации свои полные данные – юридический адрес, контактные данные, ИНН, КПП, платежные реквизиты и прочие данные. -

Сертификат недоверенного центра сертификации

Такие сертификаты выдают неизвестные центры сертификации и не гарантируют полной безопасности. Современные браузеры предупреждают пользователей, что на сайте установлен недоверенный сертификат и ресурс может использовать данные пользователя в своих целях. -

Самосозданный сертификат

Этот сертификат может сделать любой владелец ресурса. Браузер не пустит пользователя без его согласия на сайт с таким сертификатом.

Разумеется, советуем только первый вариант. Проверьте, отображается ли сертификат в браузере. При вводе любой версии сайта пользователя должно перенаправлять на главное зеркало с безопасным сертификатом.

Руководство о том, как установить SSL-сертификат и перейти на HTTPS правильно

Проверить SSL сертификат можно с помощью нашего бесплатного инструмента.

Пагинация в каталоге

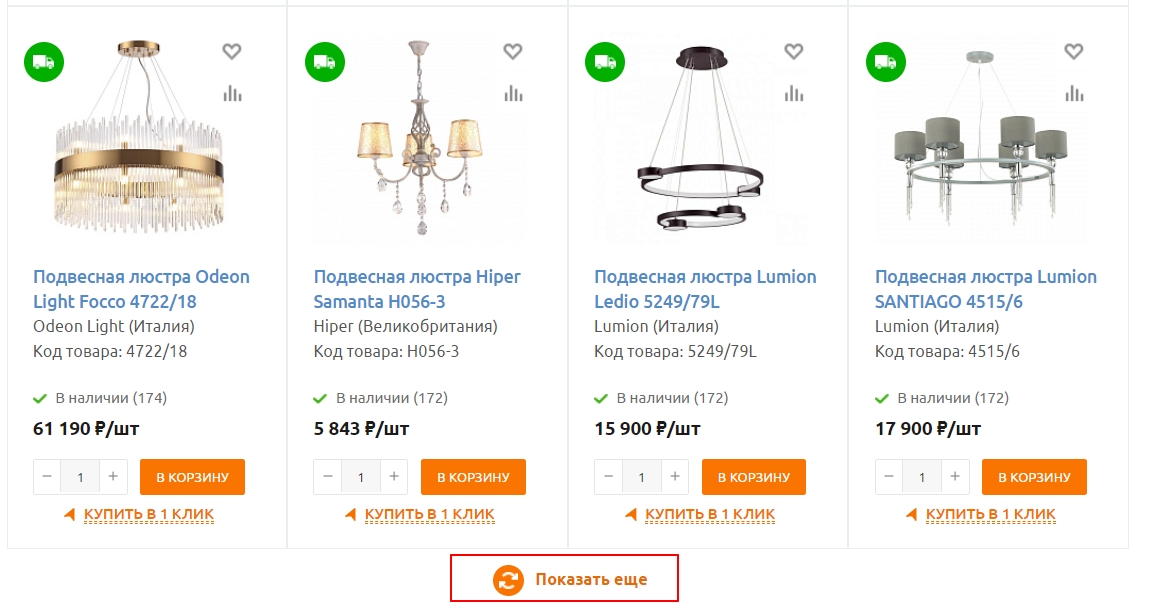

Пагинация — способ вывести на страницу ограниченное количество элементов — товаров, статей, каких-то других элементов. К примеру, в каталоге в разделе 100 диванов, но на страницы они выводятся по 20 штук.

С 2019 года rel = prev/next, которые раньше использовали для настройки, не работают ни в Яндексе, ни в Google. Есть разные актуальные способы настроить пагинацию в зависимости от того, как будет удобнее пользователям смотреть подборку.

Проверьте правильность настройки. Если вы выбрали постраничную пагинацию, как на примере:

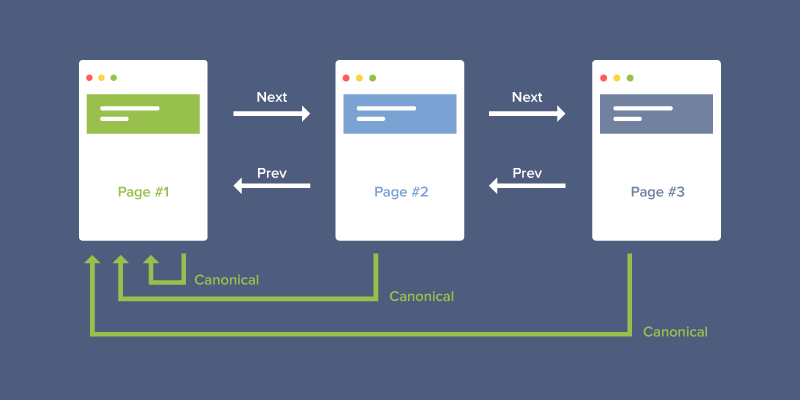

У вас получится первая страница https://site.com/catalog/koltsa/, вторая https://site.com/catalog/koltsa/?page=2 и так далее. На всех страницах, начиная с первой, нужно прописать rel = canonical с указанием на первую страницу.

Запрещать индексацию страниц тегом noindex не нужно, они должны быть доступны поисковым ботам.

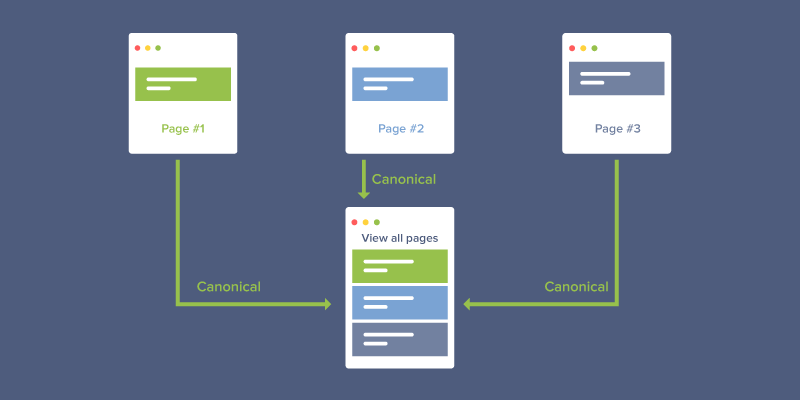

Если вы выбрали создание общей страницы со всеми товарами, то она получится самой сильной, и ее нужно указать канонической для остальных страниц каталога.

Выгодный вариант, потому что каноничной будет самая сильная страница с большинством ключей.

При динамической или бесконечной прокрутке товары автоматически подгружаются, как только пользователь долистает до низа страницы или кликнет на кнопку «Еще».

Не очень удачный вариант, поскольку сложнее настроить так, чтобы поисковая система увидела весь контент.

Подробнее обо всех вариантах и проверке корректности настройки рассказали в статье — как сделать пагинацию на сайте

Облегчите сбор информации и поиск ошибок на сайте — используйте автоматическую проверку в нашем сервисе.

В продолжении материала о самостоятельном SEO-аудите сайта разберем оптимизацию контента. Дополняйте материал в комментариях! Мы явно не могли разобрать в одной статье все, что касается SEO-аудита, так что будем рады вашим рекомендациям.

Автор:

Cosades